Was macht Maschinen intelligent? Was befähigt sie zu autonomem Handeln? Werden Roboter irgendwann einen freien Willen entwickeln? Und wo bleibt bei alldem der Mensch? Das sind einige der eher angstbesetzten Zukunftsfragen, die sich mit der Entwicklung von – im weitesten Sinne – künstlicher Intelligenz verbinden. Catrin Misselhorn, Inhaberin des Lehrstuhls für Wissenschaftstheorie und Technikphilosophie an der Universität Stuttgart, befasst sich auch aus philosophischer Perspektive mit solchen Fragen. Misselhorns neues Buch "Grundfragen der Maschinenethik" ist gerade bei Reclam erschienen.

ZEIT ONLINE: Frau Misselhorn, was macht eine Maschine, einen Algorithmus eigentlich intelligent?

Catrin Misselhorn: Die Frage nach der Intelligenz kann man leider nicht einmal in Bezug auf den Menschen eindeutig beantworten. Denn bereits bei dem gibt es sehr unterschiedliche Dimensionen von Intelligenz, etwa mathematische, räumliche oder emotionale. Die klassische Idee der künstlichen Intelligenz war: Eine Maschine ist dann intelligent, wenn sie Aufgaben lösen kann, die bei einem Menschen Intelligenz erfordern würden. Das ist aber keine befriedigende Definition. Beispielsweise würde es bei einem Menschen ein gewisses Maß an Intelligenz voraussetzen, wenn er gut im Rechnen ist. Bei einem Taschenrechner hingegen würde man das nicht als eine große Leistung betrachten. Eine Maschine wiederum, die nur Vier gewinnt spielen kann, ist nicht besonders intelligent. Denn bei dem Spiel kann man sämtliche möglichen Züge vorprogrammieren. Beim Menschen würde man auch da wieder von einem bestimmten Maß an Intelligenz ausgehen, die fürs Gewinnen dieses Spiels notwendig ist. Um von echter künstlicher Intelligenz zu sprechen, müsste eine Maschine etwa lernen und allgemeine Probleme lösen können.

ZEIT ONLINE: Was wäre ein allgemeines Problem?

Misselhorn: Um bei Vier gewinnt zu bleiben: Das wäre die Fähigkeit, auch noch vergleichbare andere Spiele und deren Regeln zu erlernen.

ZEIT ONLINE: Ist dementsprechend das größte Missverständnis in Bezug auf künstliche Intelligenz, dass diese notwendigerweise der menschlichen nachgebaut ist?

Misselhorn: Das würde ich so

sehen, ja. Das lässt sich an einem anderen Spielebeispiel erläutern, nämlich an

AlphaGo, dem Programm, das im strategischen Brettspiel Go gegen die besten menschlichen Spieler

gewonnen hat. Zumindest bei der Ursprungsversion künstlicher Intelligenz ging

es darum, dass durch das Verarbeiten großer Datenmengen gelernt wird,

spezifische Probleme zu lösen, also etwa ein komplexes Spiel wie Go zu spielen.

Wir Menschen hingegen lernen gerade nicht dadurch, dass wir große Datenmengen

verarbeiten. Menschen, und das habe ich zuletzt an meiner dreijährigen Tochter

beobachtet, kommen etwa beim Spracherwerb im Gegensatz zu einer künstlichen Intelligenz mit

erstaunlich kleinen Datenmengen aus.

ZEIT ONLINE: Wie sollte künstliche Intelligenz demnach im maschinenethischen Sinne programmiert werden?

Misselhorn: Da muss man

zwischen wissenschaftlichen und praktischen Zwecken unterscheiden. Für letztere

ist es naheliegend, spezifische Anwendungen zu schaffen. Für die Wissenschaft

hingegen ist es eine interessante Frage, ob man in irgendeiner Weise eine

menschliche Intelligenz reproduzieren kann. Das ist ja auch das große Thema der

Singularity-Bewegung, die glaubt, dass wir in absehbarer Zeit eine

Superintelligenz erschaffen können. Das halte ich allerdings für eher

unwahrscheinlich.

ZEIT ONLINE: Wozu wäre eine dem Menschen überlegene Intelligenz auch überhaupt gut? Außer sagen zu können: Wir haben sie gebaut.

Misselhorn: Richtig. Allerdings verbinden viele damit offenbar die Befürchtung, dass die Maschinen uns dann irgendwann beherrschen würden. Doch auch diese Bedrohung sehe ich derzeitig nicht. Der Klimawandel stellt eine weit akutere Gefahr für die Menschheit dar.

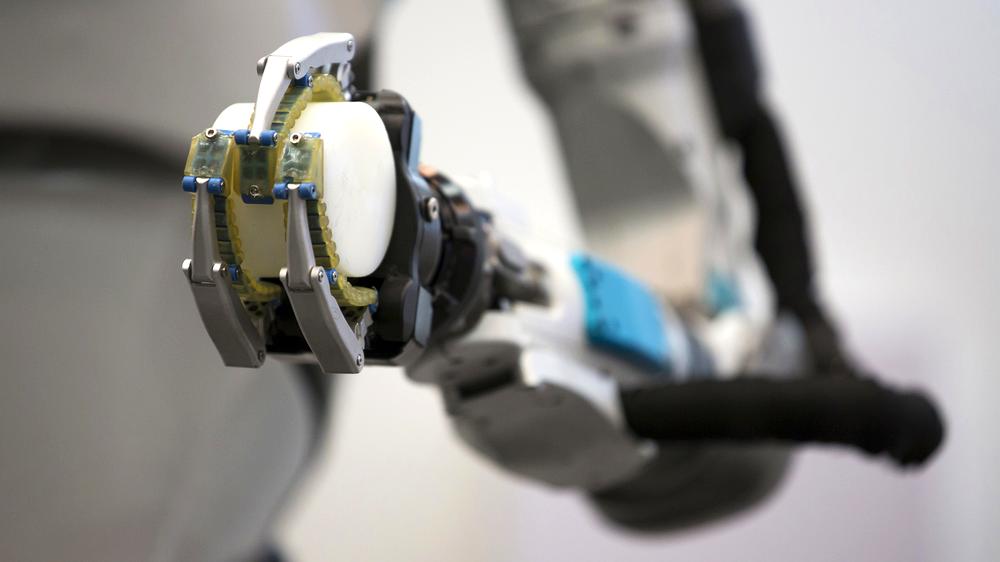

ZEIT ONLINE: Sehr konkret

Angst empfinden kann man vor bereits existierenden Maschinen wie den tier- und

menschenähnlichen Robotern der Firma Boston Dynamics (siehe Video unten):

Diese Maschinen bewegen sich wie Lebewesen und wirken von außen so, als wüssten sie, was sie tun. Ist es das, was man unter "grundsätzlicher Handlungsfähigkeit" einer Maschine versteht?

Misselhorn: Nein, das ist es noch nicht. In der gegenwärtigen Debatte gibt es zwei grundsätzliche Positionen. Für die eine beruht Handlungsfähigkeit darauf, dass wir bestimmte Dinge so wahrnehmen, als würden sie rational agieren. Die andere geht davon aus, dass Handlungsfähigkeit auf bestimmten inneren Zuständen beruht, die das Handeln verursachen. Meine Sichtweise nimmt eine Zwischenstellung ein. Ich schreibe Robotern, also Computern mit Aktoren und Sensoren, bereits Handlungsfähigkeit zu, wenn sie zwei Bedingungen erfüllen, die aus der philosophischen Handlungstheorie stammen. Die eine nenne ich Selbstursprünglichkeit, weil mir der Begriff der Autonomie zu anspruchsvoll ist. Mein Konzept ist graduell, es gibt also unterschiedliche Stufen, wie selbstursprünglich der Roboter sein kann. Die grundsätzlichste davon zeigt sich in der Fähigkeit der Maschine zur Interaktion mit der Umwelt, einer gewissen Unabhängigkeit von dieser und in einem Mindestmaß an Anpassungsfähigkeit, wenn sich Umweltbedingungen ändern.

ZEIT ONLINE: Und die zweite Bedingung?

Misselhorn: Das Handeln aus Gründen. Ein praktischer Grund ist in der Handlungstheorie die Verbindung einer Meinung und einer sogenannten Pro-Einstellung, beispielsweise einem Wunsch: Meinungen geben wieder, wie die Welt ist, Pro-Einstellungen hingegen, wie die Welt sein sollte. Kommen diese beiden Dinge zusammen, kann mich das als Mensch zum Handeln bewegen. Wenn ich etwa finde, dass es den Armen besser gehen sollte, und der Meinung bin, dies durch eine Spende für eine bestimmte Wohltätigkeitsorganisation zu erreichen, dann ist das für mich ein Grund, Geld zu spenden. Viele Philosophen sind der Ansicht, dass Maschinen keine Meinungen und Wünsche haben können. Meiner Ansicht nach können sie jedoch zumindest Zustände ausbilden, die funktional äquivalent zu Meinungen und Wünschen sind.

Was macht Maschinen intelligent? Was befähigt sie zu autonomem Handeln? Werden Roboter irgendwann einen freien Willen entwickeln? Und wo bleibt bei alldem der Mensch? Das sind einige der eher angstbesetzten Zukunftsfragen, die sich mit der Entwicklung von – im weitesten Sinne – künstlicher Intelligenz verbinden. Catrin Misselhorn, Inhaberin des Lehrstuhls für Wissenschaftstheorie und Technikphilosophie an der Universität Stuttgart, befasst sich auch aus philosophischer Perspektive mit solchen Fragen. Misselhorns neues Buch "Grundfragen der Maschinenethik" ist gerade bei Reclam erschienen.