La bibliometría es más fría que un témpano de hielo. Según el análisis de casi 35.000 investigadores realizado por Scholarmeter (empresa fundada en la Universidad de Indiana Bloomington) el científico más influyente es Karl Marx (historiador), seguido de Sigmund Freud (psicólogo) y Edward Witten (físico teórico). Quizás me digas que Marx o Freud no eran científicos, en el sentido moderno del término, pero el análisis realizado considera en pie de igualdad las ciencias sociales y las ciencias puras. ¿Cómo se ha comparado a autores de áreas tan diversas? La idea es utilizar el cociente entre el índice-h del autor y el índice-h promedio del área. Marx tiene un índice-h que es 22 veces mayor que el índice h promedio entre los historiadores, y Witten uno que es 13 veces mayor que el promedio entre los físicos, y así sucesivamente. La idea no es nueva. Hay muchas métricas «normalizadas» para poder comparar áreas diversas (artículo sobre ello en Nature), pero lo cierto es que los expertos en bibliometría no han llegado aún a un consenso sobre cuál es la mejor (si existe). Por tanto, el resultado de Scholarmeter hay que tomarlo con alfileres. Por cierto, el análisis de Scholarometer se basa en los datos de Google Scholar, cuyo valor más allá de la era de la web ha sido cuestionado por muchos expertos. Nos lo cuenta Richard Van Noorden, «Who is the best scientist of them all? Online ranking compares h-index metrics across disciplines,» News, Nature, 06 Nov 2013.

Archivo de la categoría: Índice-h de Hirsch

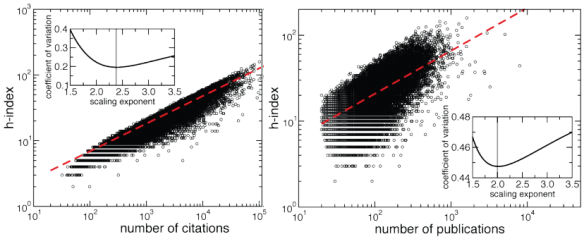

La correlación entre el índice h y el número de citas

La bibliometría está repleta de conjeturas verificadas sólo con pequeños conjuntos de datos. Tras analizar las publicaciones de 35.136 investigadores se confirma la fuerte correlación entre el índice h y el número total de citas recibidas C, siguiendo la ley de potencias h ~ C0,42, predicha por el propio Hirsch, inventor del índice h, que la verificó con un pequeño conjunto de datos. También se correlaciona con el número de publicaciones N, aunque con menor significación. La correlación entre estos tres índices bibliométricos es h ~ C0,41 N0,18. Los autores del nuevo estudio han partido de las citas de los artículos de 89.786 científicos con «profile» en Google Scholar (datos recogidos entre el 29 de junio al 4 de julio de 2012), asociados a 67.648 palabras clave diferentes; entre todos ellos han seleccionado los autores que tienen al menos 20 artículos y una carrera con más de 5 años de duración (reduciendo el número a 35.136 científicos). Esta validación a gran escala ha sido desarrollada por Filippo Radicchi, Claudio Castellano, «Analysis of bibliometric indicators for individual scholars in a large data set,» arXiv:1304.1267, 04 Apr 2013. Los aficionados a la bibliometría dispuestos a realizar otros análisis sobre los mismos datos pueden descargar dichos datos en esta página web de los autores.

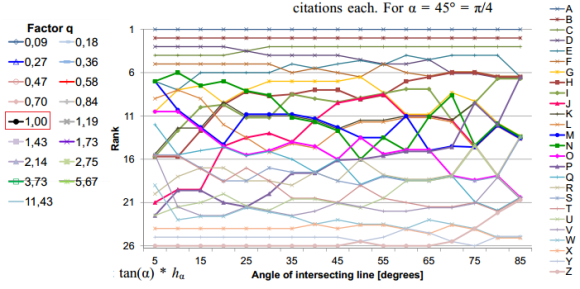

La arbitrariedad del índice h a la hora de ordenar la producción de investigadores

La arbitrariedad del índice h (propuesto por Hirsch en 2005) se hace evidente cuando se cambia un poco su definición y, en lugar de tomar el valor h como el número de publicaciones que han recibido al menos h citas cada una, se toma h como el número de publicaciones que han recibido al menos q*h citas cada una, donde q es distinto de la unidad; la costumbre es tomar q = tan(α), con q=1 para α=45 grados. El cambio parece muy pequeño, pero la estabilidad del índice h ante este «pequeño» cambio es pésima. El cambio en el orden (ranking) de una serie de investigadores al realizar un pequeño cambio en el valor de q es mucho más grande de lo que uno puede pensar en principio y hace dudar sobre la utilidad del índice h (con q=1) a la hora de ordenar investigadores por su producción. La figura muestra el ránking de 26 físicos en función del ángulo α entre 5 y 85 grados (obviamente, los primeros y últimos puestos cambian poco, pero la región intermedia, donde el índice h debe mostrar su utilidad práctica, es bastante «caótica»). Este resultado es bien conocido por los expertos en bibliometría, pero ignorado por el resto del mundo (todos los que usan el índice h a la ligera sin estudiar un «poquito» de bibliometría). Nos lo recuerda Michael Schreiber, «A Case Study of the Arbitrariness of the h-Index and the Highly-Cited-Publications Indicator,» Journal of Informetrics 7: 379-387, 2013 [arXiv:1302.6582].

«El bueno, el malo y el feo» en las revistas de acceso gratuito (open access)

El número de revistas de acceso gratuito está creciendo a un ritmo anual increíble. El último año se añadieron 1200 al listado que aparece en el Directorio de Revistas de Acceso Gratuito (DOAJ, Directory of Open Access Journals). No es un problema que haya muchas, el problema es saber cuáles son buenas y acabarán teniendo un impacto significativo en los próximos años. ¿Enviarías un artículo a revisión al Electronic Journal of Biology? ¿Son buenos los editores de Aquatic Biosystems? ¿Recomendarías a uno de tus estudiantes de doctorado o postdocs enviar un artículo al International Journal of Computer Science and Network? Estas tres revistas están entre las últimas 78 que se incorporaron al DOAJ en el último mes. Por su juventud, estas revistas aún no tienen factor de impacto en el listado de Thomson Reuters y no lo tendrán en al menos tres años. ¿Qué índice bibliométrico podemos usar para determinar la calidad de una nueva revista?

Jelte Wicherts (Univ. Tilburg, Países Bajos) propone usar un índice de transparencia, que la revista explique en su web de forma clara cosas como su temática y lectores objetivo, sus procedimientos de revisión por pares y su tasa de aceptación/rechazo. Según Wicherts, las mejores revistas del DOAJ son las más tranparentes. ¿Cómo se calcula este índice? Mediante una encuesta, de manera similar a como se valoran películas. Se pasa un cuestionario entre un muestra de investigadores y se asigna un valor del índice de transparencia a la revista. Sin embargo, a mucha gente no le gusta este tipo de medida subjetiva y prefieren un índice bibliométrico numérico, en apareciencia más aséptico.

Un nicho de investigación no es fácil de descubrir. Los especialistas en bibliometría y quienes aspiren a serlo tienen aquí un problema interesante y útil que resolver. El desarrollo de un índice bibliométrico para medir la calidad de revistas científicas emergentes, que combine sencillez y precisión, será objeto de gran número de propuestas y publicaciones en los próximos meses. La bibliometría tiene mucho intrusismo entre matemáticos y físicos, como Hirsch, el autor del famoso índice-h, quizás alguno de los lectores de este blog esté ahora mismo pensando en cómo resolver este problema bibliométrico.

A bote pronto, se me ocurre un índice de impacto potencial calculado como el exponente de la potencia en un ajuste de la evolución anual del índice-h de la revista utilizando una ley de potencias; este índice sería útil para los primeros cinco años de vida de una revista. Obviamente, sin una investigación estadística detallada que confirme la «aparente» utilidad del índice, cualquier propuesta caerá en saco roto.

Cómo predecir el impacto futuro de tus publicaciones

Seguro que no puedes esperar, pues conéctate ahora mismo a la página web H-index Predictor y predice el que será tu índice de impacto en los próximos años (el estudio se ha realizado con biólogos evolutivos y especialistas en Drosophila, luego podría ser fiable en Ciencias de la Vida en general, aunque en otros campos no lo parece tanto; en mi caso es demasiado optimista). Daniel E. Acuña (Universidad de Northwestern, Evanston, Illinois, EEUU) y dos colegas publican en Nature una fórmula capaz de predecir el impacto de las publicaciones de un investigador que haya publicado al menos durante cinco años. Su método se basa en el uso de técnicas de aprendizaje automático y algoritmos de regresión lineal. El resultado muestra una estimación del futuro índice-h del autor en los próximos 10 años. que es posible predecir la evolución del índice-h de un autor durante al menos los próximos 5 años. Las características con mayor valor predictivo son el número de artículos publicados, el número de revistas diferentes en las que se ha publicado, el número de revistas en el top de índice de impacto y el número de años desde el primer artículo. Según Acuña y sus colegas, su fórmula debería ser muy útil para los organismos que evalúan investigadores (como la ANECA en España), así como para comisiones de contratación. El artículo técnico es Daniel E. Acuña, Stefano Allesina & Konrad P. Kording, «Future impact: Predicting scientific success,» Nature 489: 201–202, 13 September 2012 (los detalles técnicos están en la información suplementaria). El editor de Nature también comenta sobre este artículo en «Count on me,» Nature 489: 177, 13 September 2012.

En un mundo ideal, los científicos nunca serían evaluados utilizando métricas bibliométricas, sino juzgando su currículum vitae mediante una evaluación por pares. Sin embargo, el coste de una evalución por pares rigurosa obliga, con frecuencia, a recurrir a la vía rápida y barata. Lo interesante del nuevo artículo es que, como se ha publicado en Nature, acabará generando un gran número de secuelas (como ya pasó con el artículo de Hirsch que se publicó en PNAS), nuevas métricas cada vez más precisas para facilitar la ingrata labor de los evaluadores. El problema de cualquier métrica es que hecha la ley, hecha la trampa.

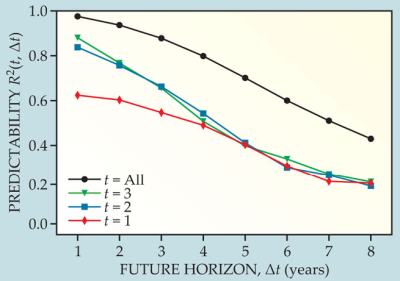

PS (30 abr 2013): El artículo de Acuña y sus colegas es criticado en Orion Penner et al., «Commentary: The case for caution in predicting scientists’ future impact,» Physics Today 66: 8, April 2013 [copia gratis]. Predecir el éxito futuro de un investigador es muy difícil. Para ilustrarlo se aplicó el modelo de Acuña a 2 profesores asistentes de física de los 50 mejores departamentos de física de EEUU (es decir, a 100 profesores). El coeficiente de determinación R²(t, Δt) es una medida estadística de lo bien que predice un modelo con un horizonte de Δt años. Se aplicó dicho análisis al índice h. El resultado muestra que la predicción es buena (curva negra), pero mirando por grupos de edad (los que llevan 1, 2, y 3 años como asistentes) se observa que la predicción es mejor para los que llevan más tiempo.

Esta limitación es importante porque se espera que el algoritmo de Acuña et al se aplique antes del primer año de profesión, para seleccionar al personal en función de su proyección futura, y es en dicho caso cuando más falla la predicción. La predicción es mejor cuando se aplica a quienes ya han sido seleccionados y llevan cierto tiempo demostrando su valía.

Este resultado está de acuerdo con muchos otros estudios que apuntan a que el impacto de los artículos publicados en el pasado no está correlacionado con el impacto de los artículos publicados en el futuro. Usar medidas bibliométricas, aunque no sea una sola, sino 5, como en el caso de Acuña et al., no mejora el poder predictivo de estas medidas. Este hecho debe ser tomado con mucho cuidado. Nunca se debe abusar de la cienciometría.

El índice h de Albert Einstein

Jorge E. Hirsch (Universidad de California, San Diego) inventó en 2005 el índice h para medir la calidad profesional de físicos y de otros científicos en función de la cantidad de citas que han recibido sus artículos científicos. Un científico tiene índice h igual a h si ha publicado h trabajos con al menos h citas cada uno. ¿Cuál es el índice h de Albert Einstein? Hirsch nos informa en Physics Today (March 2011) que según el Institute for Scientific Information (ISI) el índice h de Albert Einstein es 50. Mucho más bajo que el 125 de Edward Witten, pero hay que recordar que Einstein publicó entre 1901 y 1955, y Witten publica desde 1976. Eran otros tiempos y se publicaba mucho menos que ahora. Por ejemplo, en los seis primeros meses de Physical Review en 1948 se publicaron 1.476 páginas, mientras que en los primeros 6 meses de 1998, Physical Review A-E tienen 39.141 páginas (muchos más artículos implica muchas más referencias).

¿Cómo se compara el índice h de Einstein con el de otros científicos de su época? Werner Marx, Lutz Bornmann, y Manuel Cardona han publicado un análisis exhaustivo sobre la evolución en el tiempo del índice h gracias al cual Hirsch afirma que no concibe un físico contemporáneo a Einstein con un índice h mayor que 50. Según el Institute for Scientific Information (ISI) el índice h de Erwin Schrödinger (1914-61) es 26, el de Werner Heisenberg (1921-1976) es 30, el de Enrico Fermi (1922-55) es 32, y el de Paul Dirac (1924-85) es 44. Cardona y Marx han calculado un índice h de 41 para Max Born (1900-70) y de 45 para Heisenberg gracias a la corrección de ciertas omisiones en el ISI. Mas aún, Hirsch afirma que no conoce a ningún físico anterior a 1956 con un índice h mayor de 50. ¡Palabras mayores! Aunque Hirsch se cura en salud y nos recuerda que comparar el índice h de científicos que hayan vivido en épocas diferentes no tiene ningún sentido.

Por cierto, el índice h de Albert Einstein en 1955 era de sólo 20. «Como el buen vino, el índice h mejora conforme pasa el tiempo,» dice Hirsch.

Estos comentarios de Hirsch vienen a colación por una crítica de J. Richard Gott III al índice h en el número de noviembre de 2010 de Physics Today. Su crítica se basa en que el índice h no describe bien a Einstein y le lleva a introducir un nuevo índice que en su honor llama índice E. Pero como nos recuerdan Cardona y Marx en Physics Today (March 2011), ya existe un índice bibliométrico llamado índice e y hay más de 37 variantes del índice h publicadas en la literatura. La gran ventaja del índice de Hirsch y el motivo de su éxito es su simplicidad (por ello el artículo original de Hirsch ha recibido 660 citas en cinco años; para un artículo en bibliometría es un fenómeno único). Cardona y Marx han desarrollado una técnica para corregir el índice h con el tiempo y obtener un valor normalizado independiente de la época. Aplicando dicha técnica, el índice h normalizado de Einstein es de 139, mayor que el de Witten.

Por supuesto, Gott contesta a los demás lo que tiene que contestar. Su índice E no tiene nada que ver con el índice e, ni con el índice h normalizado y su índice E es mejor. ¡Faltaría más!

Carnaval de Matemáticas 2.1: Por qué una revista del montón (IJNSNS) tiene el mayor índice de impacto en Matemática Aplicada

La revista internacional The International Journal of Nonlinear Sciences and Numerical Simulation (IJNSNS) alcanzó en 2008 un índice de impacto de 8’91 y desde 2006 (hasta 2009) lidera la lista de revistas internacionales en el área de Matemática Aplicada del Journal Citation Reports (JCR). En 2011 ya no lo hará: IJNSNS ha cambiado de editorial (de Freund a De Gruiter) y su editor principal (Ji-Huan He) ha sido substituido (por Krishnaswamy Nandakumar). El making of del alto índice de impacto de IJNSNS, gracias a las malas artes de J.-H. He, nos lo explican Douglas N. Arnold y Kristine K. Fowler, «Nefarious Numbers,» Notices of the AMS 58: 434-437, Mach 2011 [ArXiv, 1 Oct 2010]. Más información en «Arnold & Fowler on “Nefarious Numbers” about the impact factor manipulation,» Francis’ world inside out, February 18, 2011. Esta entrada será mi primera participación en el Carnaval de Matemáticas 2.1 alojado por Tito Eliatrón Dixit.

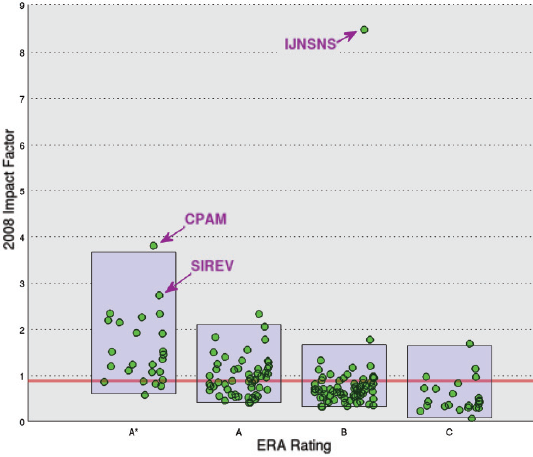

Antes de nada hay que explicar la figura que abre esta entrada. El Consejo de Investigación Australiano (Australian Research Council, el equivalente australiano al CSIC español) ha evaluado mediante encuestas a investigadores la calidad de 20.000 revistas internacionales. La calidad global de una revista puede ser A* (lo mejor en su campo), A (de muy alta calidad), B (de reputación sólida) y C (para las que no encajan en las otras categorías). La lista ERA incluye 170 de las 175 revistas internacionales impactadas de la categoría «Mathematics, Applied» del JCR de 2008. La revista #1, IJNSNS ha sido calificada como B. Las revistas #2 y #3, Communications on Pure and Applied Mathematics (CPAM) y SIAM Review (SIREV), que solo alcanzan un índice impacto de 3’69 y 2’80, resp., son revistas de categoría A*. La línea roja en la figura se ha colocado en el percentil 20% para el índice de impacto de las revistas tipo A* (lo mejor de lo mejor); hay que destacar que 51% de las revistas tipo A tienen un índice de impacto mayor que este nivel, como el 23% de las revistas tipo B y el 17% de las «peores» revistas (tipo C). Obviamente, IJNSNS es el caso más anómalo. Su índice de impacto es astronómico para ser una revista de categoría B. Entre las 10 revistas con mayor índice de impacto (JCR 2008) tenemos 7 revistas A*, 2 revistas A y solo una revista B, IJNSNS. ¿Cómo es posible que IJNSNS haya obtenido un índice de impacto tan alto?

El índice de impacto se calcula como un cociente entre las citas recibidas y el número de artículos. En 2008 se citaron 821 veces los 79 artículos de IJNSNS publicados en 2007 y 561 veces los 84 publicados en 2006, por tanto, el índice de impacto es (821+561)/(79+84)=1382/163=8’479. ¿Cómo ha logrado Ji-Huan He que IJNSNS haya obtenido un índice de impacto tan alto?

El investigador que más citas a IJNSNS ha producido en 2008 es … su editor principal, Ji-Huan He (243 citas de las 1382). El segundo citador es D. D. Ganji (con 114 citas) y el tercero Mohamed El Naschie (con 58 citas), ambos son miembros del comité editorial de la revista. Estos 3 autores son responsables del 29% de las citas que cuentan para el índice de impacto de IJNSNS. Más aún, el 71’5% de las citas en 2008 a IJNSNS son citas a artículos publicados en 2006 y 2007 (las citas que cuentan para el índice de impacto).

La revista internacional que más ha citado a IJNSNS en 2008 es el Journal of Physics: Conference Series, responsable de 294 citas (más del 20% de las 1382). Todas estas citas provienen de un solo número de esta revista, las actas de un congreso internacional organizado por… Ji-Huan He, editor principal de IJNSNS en su propia universidad. La segunda revista que más ha citado a IJNSNS en 2008 fue el Topological Methods in Nonlinear Analysis, responsable de 206 citas (el 14%) y de nuevo todas las citas provienen de un solo número de esta revista, un número especial cuyo editor invitado es … como no, Ji-Huan He. La tercera revista más citadora en 2008 a IJNSNS es la revista Chaos, Solitons and Fractals, con 154 citas; Ji-Huan He era miembro del comité editorial de CS&F y su editor principal Mohamed El Naschie es coeditor (regional) de IJNSNS. La cuarta revista más citadora es el Journal of Polymer Engineering, también de un solo número y también editado por Ji-Huan He. Ji-Huan He es responsable «directo» de más del 50% de las citas al IJNSNS en 2008.

Según el Essential Science Indicators, producido por Thomson Reuters, J.-H. He es uno de los científicos más citados de la actualidad en Matemáticas, con 6.800 citas y un índice-h de 39 (según Hirsch, inventor del índice-h, la media de los ganadores del premio Nobel de Física es 35). He y sus malas artes han logrado encumbrarle al súmmun de los científicos más citados. Por ejemplo, sólo el número especial de la revista Journal of Physics: Conference Series antes citado, editado por él mismo, contiene 353 citas a sus propios artículos. ¡Qué os voy a contar!

En este blog ya nos hemos hecho eco en varias ocasiones de las malas prácticas de He: «El editor que se autoedita, buen autoeditor es (salvo que le corten la cabeza como a El Naschie),» 27 noviembre 2008; «El presidente de SIAM y la “ingeniería” del índice de impacto de revistas internacionales,» 12 diciembre 2009; y «Una broma de mal gusto del ISI Web of Science o esto va de castaño a oscuro,» 16 junio 2009.

Lo sorprendente es que hasta el año 2009 nadie se atrevía a criticar las malas artes de J.-H. He. Imperaba una ley del silencio que destaparon una serie de blogs y una serie de artículos que criticaron la «basura» He-siana (porque sus artículos técnicos son pura «basura» no hay mejor palabra para calificarlos). En este blog nos hemos hecho eco de ello en varias ocasiones: «La cruzada de Francisco M. Fernández contra Ji-Huan He y los He-sianos, un ejemplo de la “basura” que se publica en revistas “respetables”,» 5 febrero 2009; «Nueva cruzada contra los He-sianos, pero en revistas sin índice de impacto, por ahora,» 23 abril 2009; «Nuestro cruzado, Marcelo, logra uno de los artículos más descargados en ScienceDirect,» 7 octubre 2009; «Nuevos avatares de la cruzada anti-He-siana de la mano del nuevo cruzado Sir Jason, autor del blog “El Naschie Watch”,» 2 julio 2010; ; y «Nikolai Kudryashov y la cruzada en defensa de la fe en la matemática aplicada,» 27 noviembre 2010.

Goodhart’s law warns us that “when a measure becomes a target, it ceases to be a good measure.”

Cómo incrementar tu índice h gracias a Google Scholar

El informático Ike Antkare tiene 111 artículos en Google Scholar y un índice h de 94 (atesora 94 artículos con al menos 94 citas). Un genio, si no fuera porque Ike Antkare no existe, es una invención de Cyril Labbé del Laboratorio de Informática de Grenoble en la Universidad Joseph Fourier, Francia. Todos los artículos de Antkare han sido generados por ordenador gracias a Scigen y todas las citas a sus artículos son autocitas (como es obvio). Google Scholar no distingue entre artículos escritos por un científico o generados por un programa de ordenador. Labbé nos cuenta como lo hizo en su artículo «Ike Antkare, One of the Great Stars in the Scientific Firmament,» 22th Newsletter of the International Society for Scientometrics and Informetrics, June 2010. Visto en Bee, «Fun with the h-index,» Backreaction, Jan. 10, 2011.

El trabajo de Labbé nos muestra lo fácil que es engañar a Google Scholar y con él a todas las herramientas informáticas de análisis bibliométrico basadas en él, como Publish or Perish o Scholarometer. No espero que nadie incremente de forma fraudulenta su CV gracias a Google Scholar, pero ver lo fácil que es hacerlo le hace a uno pensar sobre este asunto.

Nuevo índice h de Hirsch para medir el efecto de los coautores

Hirsch se ha hecho famoso gracias a su índice-h para medir el impacto de las publicaciones de un investigador o un grupo de ellos. Un índice de H indica que H artículos han recibido al menos H citas. Hirsch ha introducido varias variantes de su índice, la última es el índice

(hbarra). Este índice vale N si el autor tiene N artículos que tienen al menos tantas citas como el índice

del resto de sus coautores. El índice

siempre es menor o igual que el índice

, aunque muchas veces es muy parecido. Hirsch afirma que el nuevo índice tiene en cuenta el efecto del prestigio de los coautores en el número de citas recibidas. Yo no lo veo nada claro y en mi opinión este nuevo índice aporta poco a las más de 20 variantes del índice

que se han propuesto en la literatura. Para los interesados, el artículo técnico es J. E. Hirsch, «An index to quantify an individual’s scientific research output that takes into account the effect of multiple coauthorship,» ArXiv, 17 Nov 2009.

Es curioso que el propio Hirsch tenga todavía imaginación para proponer una nueva variante de su índice que no ha sido considerada en el pasado. El nuevo índice satisface y para un autor sin coautores

, aunque podría darse dicha igualdad incluso cuando hay coautores. Los artículos que se cuentan al calcular el índice

de un autor, se llama núcleo

de sus publicaciones. El núcleo

de un autor no puede decrecer, un artículo en él lo estará siempre. Sin embargo, el núcleo

de dos coautores puede ser disjunto, es decir, un artículo cuyas citas lo colocan en el núcleo

de un autor y para él cuenta para su índice

, para otro coautor puede que no esté en su núcleo

y no le cuente para el suyo. Con el índice

eso no puede ocurrir. Un artículo está en el núcleo

de todos sus coautores. Por supuesto, el núcleo

de un autor cambia con el tiempo y un artículo puede entrar y salir conforme pasa el tiempo, aunque la gran mayoría de artículos permanecerán en él por siempre.

La gran ventaja del índice es lo fácil que es calcularlo. Basta ordenar los artículos por número de citas y el índice

se ve. Sin embargo, el índice

es mucho más difícil de calcular ya que requiere considerar a todos los coautores y sus publicaciones. Nadie usará un índice tan complicado como el

. Por ello, Hirsch nos propone redefinirlo de forma «inconsistente.» Un autor tiene un índice

igual a M si M de sus artículos tienen un número de citas mayor o igual que M y dichos artículos pertenecen a los núcleo

de sus coautores. Este nuevo índice es ligeramente menor que el índice

correcto (consistente). El cálculo de este índice (versión inconsistente) require dos pasos, por un lado cribar el núcleo

del autor y por otro añadir artículos que no se encontraban en él. Este procedimiento es fácil (aunque puede ser largo) de aplicar utilizando el ISI Web of Science, pero Hirsch en su artículo nos detalla todos los pasos.

Pongamos un ejemplo de cálculo del índice . Consideremos un autor A con un índice

de 20 (tiene 20 artículos con al menos 20 citas). El artículo número 20 tiene 21 citas y tiene un único autor. El artículo 19 tiene 25 citas y tiene un coautor joven, con índice

de 5. Ambos artículos pertenecen el núcleo

de A. Los artículos 18, 17 y 16 tienen 28, 30 y 35 citas, resp., y tienen entre los coautores a los investigadores senior B, C y D con índices

45, 55 y 40. El artículo 15 tiene 43 citas y entre los coautores está D. Los artículos 18, 17 y 16 no pertenecen al núcleo

de A, pero el 15 sí. Por tanto, el índice

de A es como poco 17. ¿Por qué? Porque hay artículos que no están en el núcleo

de A que también han de ser considerados. El artículo 21 podría tener 19 citas y un único autor. Dicho artículo no contaba para el índice

pero sí cuenta para el

(pues supera a 17). Si el artículo 22 tiene 18 citas pero tiene a B como coautor y el artículo 23 tiene 17 citas, ninguno de los dos cuenta para el núcleo

y el autor A tiene un índice

de 18.

Hirsch considera que su nuevo índice permite una comparación más democrática entre autores con índice similar. Hirsch recomienda utilizar dicho índice para comparar investigadores noveles (junior) con objeto de descontar el efecto de sus coautors senior. Más aún, para obtener un buen valor del índice

conviene no tener como coautores a personas con índices

muy altos, ya que dichos artículos no nos contarán. Por ello, Hirsch cree que el uso de este índice puede favorecer que se reduzca el número de coautores (senior) de «relleno» en los artículos (que favorecen sin embargo al índice

). Yo, la verdad, no lo veo tan claro. No sé lo que opinareis vosotros al respecto.

Más información sobre quién la tiene más larga y quién los tiene más grandes

Ya lo contamos en este blog en «Quién la tiene más larga… y quién los tiene más grandes…,» el 8 de agosto de 2008, que no seáis mal pensados, que se refiere a la lista de publicaciones y a los índices de impacto de las revistas de sus publicaciones. «Así es como nos miden en el sistema universitario español.» En dicho artículo nos hacíamos eco de un informe de la IMU (Unión Matemática Internacional) de matemáticos especializados en estadística sobre los usos de la bibliometría a la hora de estudiar la calidad científica de revistas, investigadores e instituciones. El artículo se titula “Citation Statistics,” y sus autores Robert Adler, John Ewing y Peter Taylor lo acaban de publicar en la revista Statistical Science 24: 1-14 (2009) [versión gratis en ArXiv, 19 Oct 2009].

Poco más puedo decir a lo que ya dije, pero creo que es conveniente recomendar también la lectura de los comentarios que aparecen en dicha revista sobre dicho estudio (os pongo sólo el enlace en la versión ArXiv ya que en la revista basta pinchar en «next«): Bernard W. Silverman, «Comment: Bibliometrics in the Context of the UK Research Assessment Exercise,» ArXiv, 19 Oct 2009 [S.S. 24: 15-16], David Spiegelhalter, Harvey Goldstein, «Comment: Citation Statistics,» ArXiv, 19 Oct 2009[S.S. 24: 17-20], David Spiegelhalter, Harvey Goldstein, «Comment: Citation Statistics,» ArXiv, 19 Oct 2009 [S.S. 24: 21-24], Peter Gavin Hall, «Comment: Citation Statistics,» ArXiv, 19 Oct 2009 [S.S. 24: 25-26], y Robert Adler, John Ewing, Peter Taylor, «Rejoinder: Citation Statistics,» ArXiv, 19 Oct 2009 [S.S. 24: 27-28].

¡Que la fuerza … os acompañe! La bibliométrica, claro. ¡Y que los disfrutéis!