AVANCES DE CIENCIA

Peligro: algoritmos al mando en la escuela

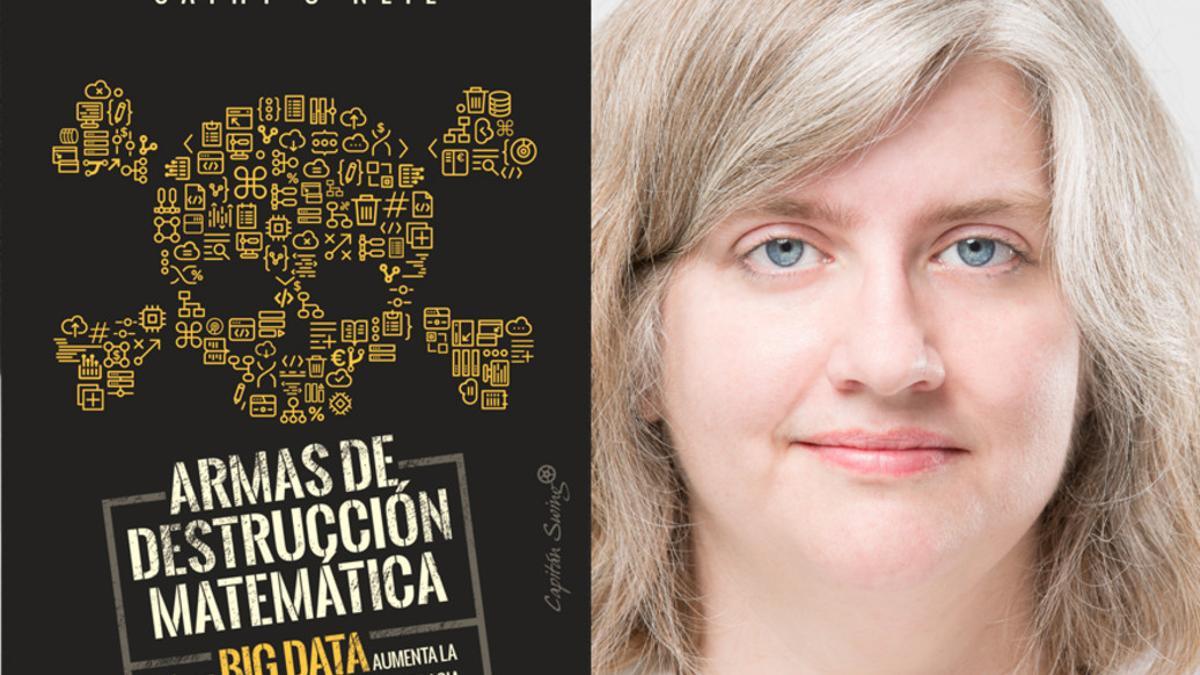

armas-de-destruccion-matematica / Capitán Swing

Extracto de “Armas de destrucción matemática” de Cathy O’Neill (Capitán Swing, 2018, traducción de Violeta Arranz de la Torre)

Selección a cargo de Michele Catanzaro

Cuando era pequeña, solía quedarme mirando el tráfico a través de la ventanilla del coche estudiando los números de las matrículas de los vehículos que pasaban. Me gustaba reducir cada matrícula a sus elementos básicos —los números primos que la componen—. 45 = 3 × 3 × 5. Esto se denomina factorización y era mi pasatiempo de investigación favorito. Yo era una empollona de matemáticas en ciernes y sentía una fascinación particular por los números primos.

Mi amor por las matemáticas acabó convirtiéndose en una auténtica pasión. Fui a un campamento de matemáticas cuando tenía catorce años y volví a casa agarrando con fuerza un cubo de Rubik contra mi pecho. Las matemáticas me ofrecían un refugio ordenado frente al desorden del mundo real. Avanzaban a grandes pasos y su ámbito de conocimiento se ampliaba inexorablemente, prueba tras prueba. Y yo podía contribuir a su desarrollo. Me especialicé en matemáticas en la facultad y decidí estudiar un doctorado. Mi tesis versaba sobre la teoría de los números algebraicos, un campo cuyas raíces estaban precisamente en esa factorización que me gustaba hacer cuando era niña. Con el tiempo, conseguí un trabajo de profesora con opción a un contrato fijo en la universidad de Barnard College, que compartía con la Universidad de Columbia el departamento de Matemáticas.

Al cabo de un tiempo, decidí cambiar radicalmente mi carrera profesional. Dejé mi puesto y empecé a trabajar como analista cuantitativa (quant en inglés) para D. E. Shaw, un destacado fondo de cobertura. Al dejar el mundo académico por las finanzas, llevé las matemáticas de la teoría abstracta a la práctica. Las operaciones que hacíamos con números se traducían en billones de dólares que pasaban de una cuenta a otra. Al principio estaba entusiasmada y asombrada con la idea de trabajar en este nuevo laboratorio, la economía mundial, pero en otoño de 2008, cuando llevaba poco más de un año en ese mundo, todo se desplomó.

La crisis financiera dejó bien claro que las matemáticas, que una vez habían sido mi refugio, no solo estaban profundamente involucradas en los problemas del mundo, sino que además agravaban muchos de ellos. La crisis inmobiliaria, la ruina de grandes entidades financieras, el aumento del desempleo: todo esto había sido impulsado e inducido por matemáticos que blandían fórmulas mágicas. Además, gracias a los extraordinarios poderes que tanto amaba, las matemáticas podían combinarse con la tecnología para multiplicar el caos y la desgracia, lo que añadía eficacia y magnitud a unos sistemas que entonces comprendí que eran defectuosos.

Si hubiéramos estado lúcidos, habríamos dado un paso atrás en este punto para analizar cómo habíamos hecho un mal uso de las matemáticas y cómo podíamos evitar una catástrofe similar en el futuro. Sin embargo, en lugar de eso, justo después de la crisis, las nuevas técnicas matemáticas estaban más de moda que nunca y se extendían a un creciente número de áreas. Funcionaban veinticuatro horas al día procesando petabytes de información, en gran parte datos extraídos de las redes sociales o de páginas web de comercio electrónico. Y en lugar de prestar cada vez más atención a los movimientos de los mercados financieros mundiales, se dedicaban cada vez más a analizar a los seres humanos, a nosotros. Los matemáticos y los especialistas en estadísticas estudiaban nuestros deseos, nuestros movimientos y nuestro poder adquisitivo. Predecían nuestra solvencia y calculaban nuestro potencial como estudiantes, trabajadores, amantes o delincuentes.

Esta era la economía del big data, y prometía ganancias espectaculares. Un programa de ordenador era capaz de procesar miles de currículos o solicitudes de préstamos en un par de segundos y clasificarlos en listas bien ordenadas, con los candidatos más prometedores situados en los primeros puestos. Estos programas no solo permitían ahorrar tiempo, sino que además se anunciaban como procesos más justos y objetivos. Al fin y al cabo, eran procesos en los que no había seres humanos, con sus prejuicios, escarbando en montones de papel, sino simplemente máquinas procesando números de manera objetiva. En el año 2010 aproximadamente las matemáticas se habían impuesto como nunca antes en los asuntos humanos, y el público en general recibió el cambio con los brazos abiertos.

Y, sin embargo, yo veía problemas en el horizonte. Estas aplicaciones fundamentadas en las matemáticas que alimentaban la economía de los datos se basaban en decisiones tomadas por seres humanos que no eran infalibles. Seguro que algunas de esas decisiones se tomaban con la mejor de las intenciones, pero muchos de estos modelos programaban los prejuicios, las equivocaciones y los sesgos humanos en unos sistemas informáticos que dirigían cada vez más nuestras vidas. Cuales dioses, estos modelos matemáticos eran opacos y sus mecanismos resultaban invisibles para todos, salvo para los sumos sacerdotes del sector: los matemáticos y los ingenieros informáticos. Sus veredictos, incluso cuando estaban equivocados o eran perjudiciales, eran indiscutibles e inapelables y solían castigar a los pobres y los oprimidos de nuestra sociedad, al tiempo que enriquecían a los ricos. Se me ocurrió un nombre para este tipo de modelos perniciosos: armas de destrucción matemática o ADM. Veamos un ejemplo, en el que iré señalando sus características destructivas poco a poco.

"Cuando el sistema de puntuación de Mathematica etiquetó a Sarah Wysocki y a otros 205 docentes como malos enseñando, el distrito escolar los despidió. Pero ¿cómo puede confirmar el sistema que su análisis fue correcto? No puede."

Como ocurre a menudo, este caso empezó con un objetivo loable. En 2007, el nuevo alcalde de Washington D. C., Adrian Fenty, estaba decidido a corregir la situación de las escuelas deficientes de la ciudad. Tenía un gran desafío por delante: en ese momento, apenas uno de cada dos alumnos de instituto llegaba a la graduación después del noveno curso (el equivalente a tercero de secundaria) y solo un 8 % de los alumnos de octavo curso (el equivalente a segundo de secundaria) tenía un nivel de matemáticas acorde a su curso. Fenty contrató a la experta en reformas educativas Michelle Rhee para que ocupara un importante puesto de nueva creación: sería nombrada rectora de los centros educativos de primaria y secundaria de Washington.

La teoría generalmente aceptada era que los alumnos no aprendían lo suficiente porque sus profesores no trabajaban bien. De modo que, en 2009, Michelle Rhee puso en marcha un plan para extirpar del sistema a los docentes de bajo rendimiento. Esta era la tendencia generalizada en los distritos escolares con problemas en todo el país y, desde el punto de vista de la ingeniería de sistemas, este razonamiento tiene mucho sentido. Hay que evaluar a los profesores, deshacerse de los peores y colocar a los mejores donde puedan producir el mayor efecto positivo posible. En el lenguaje de los científicos de datos, de este modo «se optimiza» el sistema escolar y presuntamente se garantizan mejores resultados para los alumnos. Exceptuando a los «malos» profesores, ¿quién podría no estar de acuerdo con este razonamiento? Rhee desarrolló una herramienta de evaluación del personal docente a la que llamó IMPACT y, a finales del curso académico 2009-2010, el distrito escolar despidió a todos los docentes cuyas puntuaciones los situaban en el 2 % inferior. A finales del siguiente curso, echaron a otro 5 %, es decir a 206 maestros y profesores.

No parecía que Sarah Wysocki, una maestra de quinto curso (el equivalente a quinto de primaria), tuviera nada por lo que preocuparse. Llevaba trabajando solo dos años en el colegio MacFarland, pero el director del colegio y los padres de sus alumnos tenían ya una excelente opinión de ella. En una evaluación la elogiaban por lo atenta que era con los niños; en otra se decía que era «una de las mejores maestras con las que he tratado nunca».

No obstante, a finales del curso de 2010-2011, Wysocki sacó una penosa puntuación en su evaluación de IMPACT. El problema fue un nuevo sistema de puntuación llamado modelación de valor añadido, que pretendía medir su eficacia en la enseñanza de competencias lingüísticas y matemáticas. Esa puntuación, generada por un algoritmo, representaba la mitad de su valoración global, y tenía más peso que las valoraciones positivas de los cargos directivos del colegio y de la comunidad. De modo que el distrito escolar no tuvo más remedio que despedirla, junto con otros 205 docentes que habían tenido puntuaciones de IMPACT por debajo del umbral mínimo.

No parecía tratarse de una caza de brujas ni de un ajuste de cuentas. De hecho, el enfoque del distrito escolar tenía lógica. Al fin y al cabo, los cargos directivos de los centros educativos podían ser amigos de personas que hicieran muy mal su trabajo, o quizá admiraran su estilo o su aparente dedicación. Los malos docentes pueden parecer buenos. Por lo tanto, el distrito de Washington, al igual que otros muchos sistemas escolares, decidió que debía minimizar este sesgo humano y prestar más atención a las puntuaciones basadas en resultados irrefutables: las puntuaciones de rendimiento de los alumnos en matemáticas y lectura. Los números hablarían alto y claro, prometieron los funcionarios del distrito escolar. Serían más justos.

"La crisis inmobiliaria, la ruina de grandes entidades financieras, el aumento del desempleo: todo esto había sido impulsado e inducido por matemáticos que blandían fórmulas mágicas."

Obviamente, Sarah Wysocki pensó que los números eran terriblemente injustos y quiso saber de dónde venían. «No creo que nadie los entendiera», me dijo después. ¿Cómo podía una buena maestra sacar tan malas puntuaciones? ¿Qué medía exactamente el modelo de valor añadido?

Según descubrió Sarah Wysocki, la respuesta era muy complicada. El distrito había contratado a una consultora con sede en Princeton, Mathematica Policy Research, para que creara el sistema de evaluación. Mathematica se enfrentó al reto de medir el progreso educativo de los alumnos del distrito y a continuación calcular qué parte de ese progreso o retroceso podía atribuirse a sus maestros y profesores. Evidentemente, no fue tarea fácil. Los investigadores sabían que muchas variables diferentes, desde el contexto socioeconómico de los alumnos hasta las dificultades de aprendizaje, podían afectar a los resultados de los alumnos. Los algoritmos tenían que tener en cuenta dichas diferencias, lo que explicaba en parte por qué eran tan complejos.

Efectivamente, intentar reducir el comportamiento, el rendimiento y el potencial humanos a algoritmos no es tarea fácil. Para comprender lo que intentaba evaluar Mathematica, imaginemos a una niña de diez años de un barrio pobre del sureste de Washington D. C. Al final de un curso escolar, hace la prueba homologada de quinto curso. Y luego la vida sigue. Puede que haya problemas en su familia o que tengan dificultades económicas. Quizá se muden a una nueva casa o a la niña le preocupen los problemas que tiene su hermano mayor con la ley. Tal vez esté descontenta con su peso, o quizá esté asustada porque la acosan en el colegio. Pase lo que pase, al final del curso siguiente hace otra prueba homologada, la prueba diseñada para los alumnos de sexto curso.

Al comparar los resultados de ambas pruebas, la puntuación debería mantenerse estable o, con suerte, subir. Mientras que si sus resultados caen en picado, resulta fácil calcular la diferencia entre su rendimiento y el de los alumnos con buenos resultados.

Pero ¿qué parte de esa diferencia es responsabilidad de su maestra? Es difícil saberlo, y los modelos de Mathematica solo pueden comparar unas cuantas cifras. En empresas de big data como Google, por el contrario, los investigadores están constantemente haciendo pruebas y controlan miles de variables. Pueden preparar dos versiones de un mismo anuncio —una con las letras en azul y otra en rojo—, presentar cada una de estas versiones a diez millones de personas y hacer un seguimiento para saber cuál de las dos recibe más clics. Utilizan esta retroalimentación para pulir sus algoritmos y ajustar su funcionamiento. Aunque considero que Google presenta muchos problemas, como veremos más tarde, es cierto que en este tipo de pruebas hace un uso efectivo de las estadísticas.

Intentar calcular el impacto que una persona puede tener sobre otra a lo largo de un curso escolar es un proceso mucho más complejo. «Hay tantos factores implicados en la enseñanza y en el aprendizaje que sería muy difícil medirlos todos», decía Sarah.

Por otra parte, intentar puntuar la eficacia de un docente analizando los resultados de una prueba de solo veinticinco o treinta alumnos no tiene solidez estadística y es incluso ridículo. El número de valores es insuficiente si se tiene en cuenta todo lo que puede fallar. De hecho, si quisiéramos analizar a los docentes con el rigor estadístico de un motor de búsqueda, tendríamos que probarlos en miles o incluso millones de alumnos seleccionados al azar. Los estadísticos utilizan grandes cifras para compensar las excepciones y las anomalías (y las ADM, como veremos más adelante, a menudo castigan a personas concretas que resultan ser la excepción).

Otro aspecto igualmente importante es que los sistemas estadísticos requieren una retroalimentación, algo que les indique cuándo se están desviando. Los estadísticos utilizan los errores para enseñar a sus modelos y hacerlos más inteligentes. Si Amazon.com empleara una correlación defectuosa y empezara a recomendar libros sobre el cuidado del césped a chicas adolescentes, el número de clics caería en picado y la empresa se aseguraría de corregir el algoritmo hasta que funcionara bien. Sin embargo, si no se tiene en cuenta la retroalimentación, un motor estadístico puede seguir realizando análisis defectuosos y perjudiciales sin aprender nunca de sus errores.

"Estas aplicaciones fundamentadas en las matemáticas que alimentaban la economía de los datos se basaban en decisiones tomadas por seres humanos que no eran infalibles. […] Muchos de estos modelos programaban los prejuicios, las equivocaciones y los sesgos humanos en unos sistemas informáticos que dirigían cada vez más nuestras vidas."

Muchas de las ADM de las que hablaré en este libro, incluido el modelo de valor añadido del distrito escolar de Washington, se comportan así. Definen su propia realidad y la utilizan para justificar sus resultados. Este tipo de modelo se autoperpetúa y es altamente destructivo —y además está muy extendido—. Cuando el sistema de puntuación de Mathematica etiquetó a Sarah Wysocki y a otros 205 docentes como malos enseñando, el distrito escolar los despidió. Pero ¿cómo puede confirmar el sistema que su análisis fue correcto? No puede. El sistema decidió él solito que estos docentes eran un desastre y los trataron como tal. Doscientos seis «malos» enseñantes menos. Este simple hecho ya parece demostrar lo efectivo que es el modelo de valor añadido: está limpiando el distrito de los maestros de bajo rendimiento. En lugar de buscar la verdad, la puntuación que produce el modelo la personifica.

Este es un ejemplo del bucle de retroalimentación de un ADM. Veremos muchos otros en este libro. Las empresas, por ejemplo, utilizan cada vez más las calificaciones de solvencia crediticia para evaluar a los posibles candidatos. Se basan en la creencia de que las personas que pagan pronto sus facturas tienen más probabilidades de llegar puntualmente a su puesto de trabajo y de cumplir las normas. Aunque en realidad hay muchas personas responsables y buenos trabajadores que tienen mala suerte y cuya calificación crediticia cae en picado. No obstante, esta idea de que una mala calificación crediticia está relacionada con un mal rendimiento en el trabajo hace que las personas que tienen una calificación más baja tengan menos probabilidades de encontrar trabajo. El desempleo los empuja a la pobreza, lo que a su vez empeora aún más sus calificaciones de solvencia, con lo que les resulta aún más difícil encontrar trabajo. Es una espiral que se retroalimenta. Y las empresas nunca descubren cuántos buenos empleados han dejado de contratar por centrarse únicamente en las calificaciones crediticias. En las ADM, hay muchas premisas perniciosas camufladas bajo las matemáticas y se mantienen sin que nadie las verifique ni las cuestione.

Esto nos lleva a hablar de otra característica común de las ADM: suelen castigar a los pobres. Esto se debe, en parte, a que han sido diseñadas para evaluar grandes cantidades de personas. Están especializadas en trabajar con grandes volúmenes, y son baratas. Eso forma parte de su atractivo. Los ricos, en cambio, reciben a menudo un trato más personal. Un bufete de abogados de clase alta o un exclusivo instituto privado se basarán más en recomendaciones y entrevistas personales durante los procesos de selección que una cadena de comida rápida o un distrito escolar urbano con escasos fondos. Los privilegiados, como veremos una y otra vez, son analizados por personas; las masas, por máquinas.

El hecho de que Sarah Wysocki no consiguiera encontrar a nadie que le pudiera explicar su pésima puntuación también es muy revelador. Los veredictos de las ADM son como los dictados de los dioses de los algoritmos. El modelo en sí es una caja negra, su contenido, un secreto corporativo fieramente guardado. De este modo, las consultoras como Mathematica pueden cobrar más, aunque este secretismo sirve también a otros propósitos: se supone que, si las personas evaluadas no saben cómo se hace la evaluación, es menos probable que intenten engañar al sistema. Y así no les quedará otra alternativa que simplemente trabajar duro, cumplir las normas y rezar por que el modelo registre y valore sus esfuerzos. Por otra parte, al esconder los detalles de su funcionamiento, también resulta más difícil cuestionar la puntuación resultante o protestar contra ella.

Durante años, los docentes de Washington se quejaron de las puntuaciones arbitrarias y pidieron los detalles de los aspectos que se valoraban. Es un algoritmo, les dijeron, es muy complejo. Esto disuadió a muchos de seguir presionando. Desgraciadamente, hay muchas personas que se sienten intimidadas por las matemáticas. Pero Sarah Bax, una profesora de Matemáticas, siguió presionando al administrador del distrito, Jason Kamras, un antiguo colega suyo, para que le diera los detalles. Después de meses de tira y afloja, Jason Kamras le dijo que esperara un poco, que se publicaría pronto un informe técnico. Sarah Bax le contestó: «¿Cómo puedes justificar el hecho de que estéis evaluando a personas con un método que no sois capaces de explicar?». Pero esa es precisamente la naturaleza de las ADM. El análisis se subcontrata a programadores y estadísticos, y, por lo general, dejan que sean las máquinas las que hablen.

A pesar de todo, Sarah Wysocki sabía que las puntuaciones de las pruebas estandarizadas de sus alumnos tenían un gran peso en la fórmula. Y tenía ciertas sospechas sobre ese punto. Antes de empezar el que sería su último curso en el centro de enseñanza media MacFarland, se había llevado una alegría al descubrir que sus nuevos alumnos de quinto curso habían tenido unas notas sorprendentemente buenas en las pruebas que habían hecho al finalizar el curso anterior. En el centro de primaria Barnard, del que venían muchos de sus alumnos, el 29 % de los alumnos obtuvo la calificación de «nivel avanzado» en lectura. Era un porcentaje cinco veces mayor que la media del distrito escolar.

Sin embargo, cuando empezaron las clases, Sarah descubrió que a muchos de sus alumnos les costaba leer incluso frases sencillas. Mucho después, los periódicos Washington Post y USA Today publicaron que se había descubierto un alto número de tachaduras en las pruebas homologadas de 41 centros escolares del distrito, incluido el Barnard. Encontrar un alto número de respuestas corregidas apunta a una mayor probabilidad de que se hayan hecho trampas en el examen. En algunos centros se sospechaba de hasta el 70 % de las clases.

"Intentar reducir el comportamiento, el rendimiento y el potencial humanos a algoritmos no es tarea fácil."

¿Y qué tiene esto que ver con las ADM? Pues un par de cosas. En primer lugar, los algoritmos de evaluación de docentes son una herramienta poderosa para la modificación del comportamiento. Ese es su propósito, y en los centros educativos de Washington sirvieron al mismo tiempo de palo y de zanahoria. Los maestros sabían que si sus alumnos tropezaban en la prueba, sus propios empleos estarían amenazados. Y esto supuso una fuerte motivación para los maestros, que querían asegurarse de que sus alumnos aprobarían, especialmente en un momento en el que la Gran Recesión azotaba el mercado laboral. Al mismo tiempo, si sus alumnos obtenían mejores resultados que otros alumnos del mismo curso, los maestros y los directivos de los centros recibirían primas de hasta 8.000 dólares. Si se combinan estos poderosos incentivos con las pruebas del caso —el alto número de respuestas borradas y las puntuaciones anormalmente altas en las pruebas—, hay razones para sospechar que los maestros de cuarto curso, cediendo ante el miedo o la codicia, habían corregido los exámenes de sus alumnos.

Esto significa que existe la posibilidad de que los alumnos de quinto curso de Sarah Wysocki empezaran el curso escolar con unas puntuaciones artificialmente infladas. Si esto fue así, los resultados que obtuvieron al final del quinto curso condujeron a la falsa conclusión de que sus competencias habían retrocedido… y de que tenían una mala maestra. Sarah estaba convencida de que este había sido su caso. Esta explicación encajaría con los comentarios de los padres, los compañeros y su director, que decían que era una buena docente. Esto aclararía toda la confusión. Sarah Wysocki tenía argumentos sólidos.

Sin embargo, no es posible apelar la decisión de un ADM. Esto forma parte de su temible poder. No escuchan. Ni se doblegan. Son sordas, y no solo al encanto, las amenazas y las adulaciones, sino también a la lógica, incluso cuando hay buenas razones para cuestionar los datos que alimentan sus conclusiones. Sí, es cierto que si resulta evidente que los sistemas automatizados están metiendo la pata de forma vergonzosa y sistemática, los programadores abrirán los sistemas y retocarán los algoritmos, pero en casi todos los casos los programas emiten veredictos inquebrantables, y a los seres humanos que los utilizan solo les queda encogerse de hombros como si dijeran: «Bueno, ¿y qué podemos hacer?».

Y esa es precisamente la respuesta que Sarah Wysocki recibió finalmente del distrito escolar. Jason Kamras declaró después al Washington Post que las tachaduras eran «sugerentes» y que era posible que hubiera algún error en las puntuaciones de los alumnos de quinto curso de Sarah Wysocki, pero que las pruebas no eran concluyentes. Según Jason Kamras la habían tratado con justicia.

¿Es clara la paradoja? Un algoritmo procesa un montón de estadísticas y produce como resultado una cierta probabilidad de que una persona concreta pueda ser un mal empleado, un prestatario de riesgo, un terrorista o un pésimo maestro. Esa probabilidad se condensa en una puntuación, que puede llegar a destrozar la vida de alguien. Y, sin embargo, cuando esa persona decide defenderse, las «sugerentes» pruebas en contra del veredicto son insuficientes para aclarar las cosas. El caso debe quedar blindado. Como veremos a lo largo de este libro, en lo que a las pruebas se refiere, las víctimas humanas de las ADM tienen que responder a un nivel de exigencia mucho mayor que los propios algoritmos.

Después de la terrible sorpresa de su despido, Sarah Wysocki solo estuvo unos cuantos días en paro. Había mucha gente dispuesta a responder por su trabajo como maestra, entre ellas su director, y en seguida la contrataron en un colegio de un próspero distrito al norte de Virginia. La consecuencia final fue que, gracias a un modelo altamente cuestionable, un colegio pobre perdió a una buena maestra, y un colegio rico que no despedía a los docentes por las puntuaciones que obtuvieran sus alumnos ganó una.

- García-Castellón y Gadea dejarán sus plazas en la Audiencia Nacional y Pedraz sopesa hacerse con el juzgado del Tsunami, por Ernesto Ekaizer

- El río subterráneo más largo de Europa está en España: nadie conoce su nacimiento ni su desembocadura

- Airbnb aconseja a los propietarios que no anuncien las piscinas en sus alojamientos turísticos

- Vuelve Moisés a Pasapalabra: el concursante desvela los problemas que sufrió en el pasado y por los que tuvo que abandonar el programa

- La Junta Electoral avala la candidatura de Puigdemont y rechaza la impugnación de Cs

- El invierno vuelve por Sant Jordi: los meteorólogos alertan del fenómeno que nos espera la próxima semana en Catalunya

- La vida de Rosa Peral en prisión: ¿A cuántos años está condenada? ¿Cómo es su día a día? ¿Qué estrategia seguirá en adelante?

- El Barça vive una tragedia insoportable ante el PSG