Unos sencillos cambios en el hardware y técnicas de aprendizaje automático transforman la cámara en un sensor de profundidad

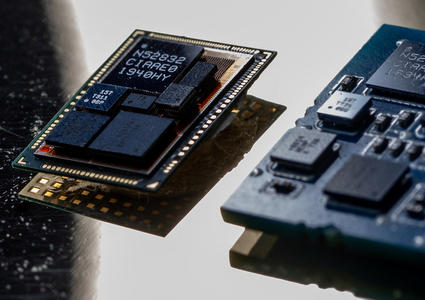

Foto: Con unos pocos cambios en el hardware, como un anillo de LED de infrarrojo cercano, se adapta una LifeCam de Microsoft para que funcione como cámara de profundidad.

Foto: Con unos pocos cambios en el hardware, como un anillo de LED de infrarrojo cercano, se adapta una LifeCam de Microsoft para que funcione como cámara de profundidad.

Ahora prácticamente todo el mundo lleva una cámara encima gracias a los móviles, pero muy pocos de estos dispositivos capturan los contornos tridimensionales de un objeto como hacen las cámaras de profundidad, que cobran cada vez más protagonismo por su potencial en los dispositivos de bolsillo. La idea es que si nuestros teléfonos pueden capturar los contornos de todo, desde las esquinas de las calles hasta la disposición de tu salón, los desarrolladores podrían crear aplicaciones que irían desde mejores juegos interactivos a guías útiles para quienes tienen problemas de vista.

Sin embargo, mientras que proyectos como Project Tango de Google se dedican a añadir cámaras de profundidad a aparatos móviles, nuevas investigaciones de Microsoft demuestran que con unas sencillas modificaciones y técnicas de aprendizaje automático, una cámara común de smartphone y una webcam se pueden usar como una cámara de profundidad 3D. La idea es facilitar el desarrollo aplicaciones en 3D reduciendo el coste y las barreras técnicas de entrada para este tipo de dispositivos, y hacer que las cámaras de profundidad 3D sean mucho más pequeñas y consuman menos energía.

Foto: Investigadores de Microsoft modificaron la cámara de un 'smartphone' para que pudiera capturar la profundidad de manos y caras.

Foto: Investigadores de Microsoft modificaron la cámara de un 'smartphone' para que pudiera capturar la profundidad de manos y caras.

Un grupo de Microsoft Research dirigido por Sean Ryan Fanello, Cem Keskin y Shahram Izadi ha presentado un artículo sobre su trabajo en Siggraph, una conferencia sobre gráfica informática e interacción celebrada en Vancouver (Canadá).

Para modificar las cámaras, el grupo retiró el filtro de infrarrojo cercano, que se suele usar en las cámaras corrientes para bloquear las señales de luz no deseada en las imágenes. Después añadieron un filtro que sólo permitía el paso de la luz infrarroja junto con un anillo de varios LED baratos de infrarrojo cercano. Haciendo esto, básicamente consiguen que cada cámara funcione como una cámara de infrarrojos.

Foto: Con algunas modificaciones, los investigadores de Microsoft pueden usar cámaras normales para dibujar la profundidad de manos y caras.

Foto: Con algunas modificaciones, los investigadores de Microsoft pueden usar cámaras normales para dibujar la profundidad de manos y caras.

"Es como si hubiéramos vuelto a la cámara del revés", señala Izadi.

El equipo de Microsoft afirma que quería usar la intensidad reflectora de la luz infrarroja como una especie de cruce entre una señal sónar y una linterna en un cuarto oscuro. La luz rebotaría de los objetos cercanos y volvería al sensor con la intensidad correspondiente. Los objetos son luminosos cuando están cerca y más apagados cuando están lejos, algo que nos resulta intuitivo cuando se trata de la luz visible. Pero el grupo tenía que entrenar las máquinas (en este caso un teléfono Samsung Galaxy Nexus y una cámara web Microsoft LifeCame) respecto a esa relación para que la cámara pudiera decidir si estaba viendo, por ejemplo, una mano grande a distancia o una mano pequeña de cerca.

Para este proyecto los investigadores decidieron centrarse en un único desafío: el modelado de manos y caras humanas, no todo tipo de objetos y entornos. Tras construir una serie de datos de entrenamiento en la que se incluían imágenes de manos, el grupo halló que podía medir los movimientos de una persona a una velocidad de 220 fotogramas por segundo. En una demostración el grupo enseña cómo este tipo de seguimiento se podría usar para navegar por un mapa, haciendo movimientos de agarrar, por ejemplo, o separando las manos, o para jugar a un juego sencillo como cortar virtualmente un plátano en el aire.

Foto: El algoritmo de aprendizaje automático de los investigadores de Microsoft usa la mano capturada por una cámara modificada que funciona como cámara de profundidad (izquierda) para producir un cálculo de su profundidad (derecha).

Foto: El algoritmo de aprendizaje automático de los investigadores de Microsoft usa la mano capturada por una cámara modificada que funciona como cámara de profundidad (izquierda) para producir un cálculo de su profundidad (derecha).

Aunque los datos de entrenamiento se centraban en caras y manos, en realidad la intención del grupo no era entrenar a las máquinas para reconocer manos o caras tal y como nosotros las vemos, sino las propiedades de reflexión de la piel. Usar grandes cantidades de datos para entrenarse permite a la máquina crear una cantidad suficiente de asociaciones con los datos de las fotos como y poder usar las propiedades adicionales de la imagen para calcular la profundidad. Microsoft eligió la piel dado que tiene muchas implicaciones a la hora de navegar por entornos de la Xbox y de Windows. Pero Kohli señala que las técnicas de aprendizaje automático son trasferibles a cualquier otra cosa.

"La única limitación es qué clase de datos de entrenamiento le das", afirma. "El enfoque en sí mismo puede hacerse a medida para que funcione en cualquier otro escenario".